生成式 AI 模型正在迅速進化,並提供無可比擬的精密性與功能。這項技術進展得以讓各產業的企業與開發人員解決複雜的問題,並發掘新商機。不過生成式 AI 模型的成長,也導致訓練、調整與推論方面的要求變得更加嚴苛。過去五年來,生成式 AI 模型的參數每年增加十倍,現今的大型模型具有數千億、甚至數兆項參數,即便使用最專門的系統,仍需要相當長的訓練時間,有時需持續數月才能完成。此外,高效率的 AI 工作負載管理需要一個具備一致性、且由最佳化的運算、儲存、網路、軟體和開發框架所組成的整合式 AI 堆疊。

為解決這些難題,今天我們很高興宣布推出 Cloud TPU v5p,這是 Google 目前功能最強大、擴充能力最佳,且最具有彈性的 AI 加速器。長久以來,TPU 一直是用來訓練、服務 AI 支援的產品之基礎,這類產品包含 YouTube、Gmail、Google 地圖、Google Play 及 Android。事實上,Google 日前宣布推出功能最強大、最通用的 AI 模型 Gemini 便是使用 TPU 進行訓練與服務。

此外,我們也宣布推出 Google Cloud AI Hypercomputer。AI Hypercomputer 是 Google Cloud 的突破性超級電腦架構,採用整合式系統,並結合了效能最佳化硬體、開放式軟體、領先機器學習架構及靈活彈性的消費模式。傳統上通常是以零碎的方式,在元件層級進行增強以處理要求嚴苛的 AI 工作負載需求,而這可能導致效率不佳,或出現瓶頸。相較之下,AI Hypercomputer 採用系統層級的協同設計來提升 AI 訓練、調整與服務的效率與生產力。

探索 Cloud TPU v5p:Google Cloud 目前功能最強大、擴充能力最佳的 TPU 加速器

上個月,我們宣布全面推出 Cloud TPU v5e。相較於上一代的 TPU v4,Cloud TPU v5e 的性價比提高了 2.3 倍,是我們目前最具成本效益的 TPU。而 Cloud TPU v5p,則是我們目前功能最強大的 TPU。每個 TPU v5p Pod 均由 8,960 個晶片組成,透過 我們頻寬最高的晶片間互連網路(Inter-chip Interconnect, ICI)相連,採用 3D 環面拓撲,提供每晶片 4,800 Gbps 的速度。相較於 TPU v4,TPU v5p 每秒的浮點運算次數(FLOPS)提高 2 倍以上,高頻寬記憶體(High-bandwidth Memory, HBM)則增加 3 倍。

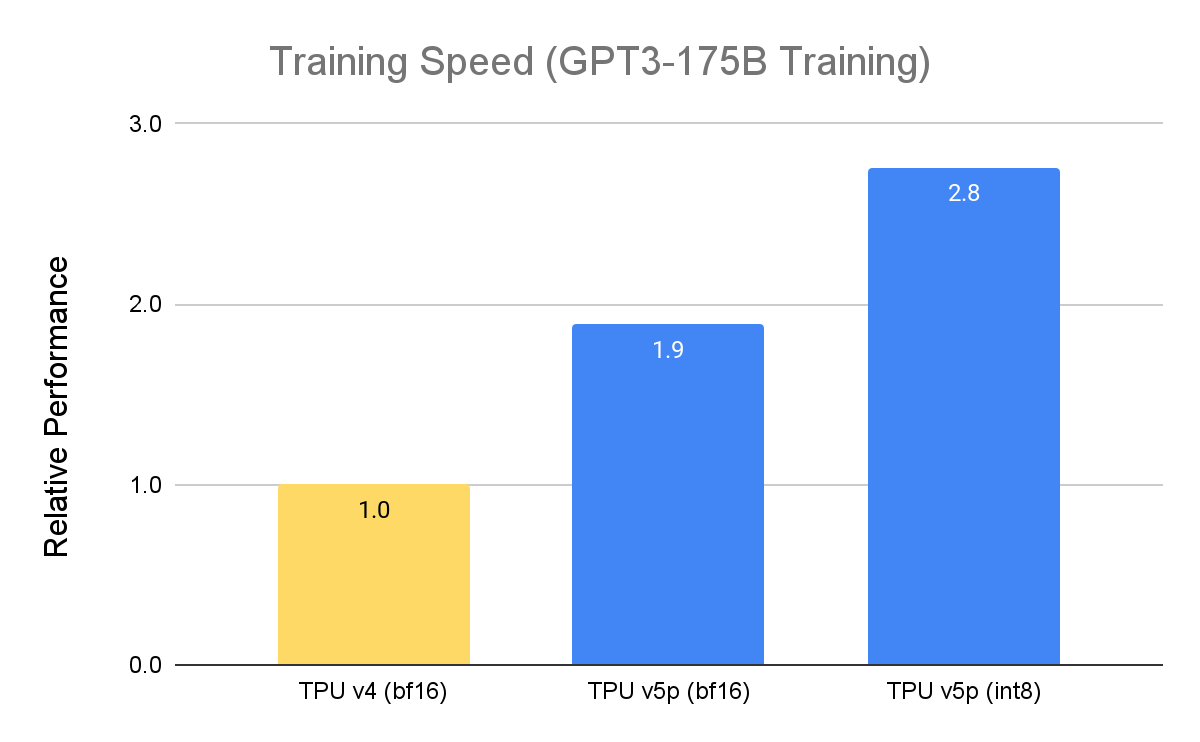

TPU v5p 專為效能、彈性與大規模作業而設計,相較於前一代的 TPU v4,TPU v5p 訓練大型 LLM 模型的速度提升 2.8 倍。不僅如此,若搭配第二代 SparseCores,TPU v5p 訓練嵌入密集模型的速度較 TPU v4 快 1.9 倍[1]。

資料來源:Google 內部資料,截至 2023 年 11 月, GPT3-175B的所有數據均以晶片為單位完成標準化作業